Quality/Quality/de

In was für einer Qualitäts-Landschaft agiert Wikimedia?

Wikimedia und Qualität

Ed Chi und seine Mitarbeiter von PARC fassen die Methode von Wikimedia, um Qualität zu erreichen, so zusammen: Weil jeder überall mitschreiben und den Editierungsverlauf eines Artikels genau verfolgen kann, wird es zu einer verlässlichen Informationsquelle.

Er führt weiter aus, dass dieser innovative und transparente Prozess tatsächlich gängigen akademischen Prozessen zur Wahrheitsfindung ähnelt:

- Jeder kann nachforschen und Fragen stellen

- Falschangaben können korrigiert werden

- Umstrittene Meinungen können nebeneinander aufgeführt werden

Allerdings wird oft gefragt, wie man am besten die Ergebnisse und den Erfolg dieser Art der Qualitätssicherung messen kann. Mögliche Qualitätskriterien für Wikimedia-Inhalte gibt es viele, darunter:

- Korrektheit

- Zuverlässigkeit

- Vollständigkeit

- Neutralität

Eine „Antwort“ über die empfundene und tatsächliche Qualität von Wikimedia zu finden, wird durch die Größe und Beliebtheit der Wikipedia noch erschwert. Wie Simson Garfinkel darstellt, haben die Größe und öffentliche Präsenz der Wikipedia, zusammen mit ihren Aufnahmestandards, einen neuen Rahmen für das Abwägen der „Wahrheit“ in Wikimedia-Informationen geschaffen. In einem aktuellen Technology Review-Artikel erklärt er weiter, dass "der Aufnahmestandard der Wikipedia ihr de-facto-Standard für Wahrheit geworden ist, und da Wikipedia das meistgelesene Online-Nachschagewerk der Welt ist, ist sie ein Standard für Wahrheit, der von den meisten vorbehaltlos genutzt wird, wenn sie einen Suchbegriff bei Google oder Yahoo eingeben. Auf Wikipedia wird Wahrheit als Wahrheit angesehen: die Konsensansicht zu einem Thema." [1]

Inhaltliche Richtlinien

Obengenanntes bezieht sich direkt auf die drei wichtigsten inhaltlichen Richtlinien der Wikipedia, die die Qualität der Inhalte im Artikelnamensraum festlegen:

- Nachprüfbarkeit. Unter (en)Wikipedia:Verifiability heißt es: „Die Schwelle zur Aufnahme in die Wikipedia ist Nachprüfbarkeit, nicht Wahrheit - das heißt, ob der Leser überprüfen kann, dass zur Wikipedia hinzugefügtes Material bereits von einer verlässlichen Quelle veröffentlicht wurde, und nicht, ob wir es für wahr halten.“ Verlässliche Quellen werden im allgemeinen als „Review-Artikel, die von Universitäten herausgegeben werden; Universitäts-Lehrbücher; Magazine, Zeitschriften und Bücher, die von angesehenen Verlagen herausgegeben werden; und etablierte Zeitungen. Auch elektronische Medien dürfen verwendet werden. Als Faustregel gilt, je sorgfältiger die Prüfung von Tatsachen, Rechtsfragen, Beweisen und Argumenten durchgeführt wurde, desto verlässlicher ist die Quelle“.

(In der deutschen Wikipedia: Wikipedia:Belege

- Neutraler Standpunkt. Wikipedia:Neutraler Standpunkt besagt: „Um den neutralen Standpunkt zu wahren, müssen Wertungen ausgewogen sein und alle maßgeblichen Standpunkte repräsentieren (es darf kein verstecktes Werturteil durch die Auswahl oder Gewichtung einzelner Sichtweisen erfolgen).“

- Keine Theoriefindung. Auf Wikipedia:Keine Theoriefindung heißt es dazu: „Wikipedia bildet bekanntes Wissen ab. Sie dient der Theoriedarstellung, nicht der Theoriefindung oder Theorieetablierung. Als Theoriefindung gelten Aussagen, die in keiner anerkannten Fachliteratur veröffentlicht sind. Das betrifft insbesondere unveröffentlichte Theorien, Daten, Aussagen, Konzepte, Methoden oder Argumente, aber auch eigene Interpretationen veröffentlichter Daten und Analysen. Ebenso unerwünscht sind Begriffsbildungen und Wortschöpfungen.“

Ein Qualitätsmaßstab oder mehrere?

Des weiteren muss man sich die Frage stellen, ob es überhaupt möglich ist, eine einzige Definition von Qualität auf alle Inhalte anzuwenden. Zwei Argumentationen wären möglich:

- Qualität ist komplett objektiv beurteilbar, und alle Wikimedia-Inhalte können und müssen dem selben Qualitätsmaßstab entsprechen

- Der Qualitätsmaßstab variiert je nach Benutzer, Zweck und Kategorie/Thema (d.h. Standards für spezielle Bereiche)

Könnte es weitere Möglichkeiten geben? Welche Argumente können für oder gegen die eine oder andere Seite gefunden werden?

Was ist der aktuelle Stand der Qualität von Wikimedia?

Überblick über Lob und Tadel für die Qualität

Einfache Statistiken scheinen zu bestätigen, dass diese Grundrichtlinien funktionieren, und dass Benutzer die Qualität der Wikipedia hoch einschätzen:

(Daten bitte ergänzen)

- X Millionen Freiwillige haben über YY Millionen Beiträge zu Z Millionen Artikeln verfasst

- Die englische Wikipedia ist derzeit die XX. meist besuchte Seite im Internet und hat durchschnittlich XX,000 Suchanfragen pro Sekunde

- „Wikipedia tauscht Autorität gegen Zugänglichkeit, Umfang und Geschwindigkeit. Für gewöhnlich kostet es Geld, eine professionell gestaltete Enzyklopädie zu nutzen. Wikipedia hingegen ist kostenlos verfügbar. User, die sich für das eine oder andere Thema interessieren, werden die einfache Erreichbarkeit der Wikipedia als wert genug empfinden, das Risiko, gelegentlich getäuscht zu werden, auf sich zu nehmen“ [2]

Einige behaupten hingegen, das Wahrnehmen von Qualitätsproblemen in der Wikipedia untergrabe das gesamte Projekt, ungeachtet der tatsächlichen Qualität. Weitergedacht besagt diese Logik, dass trotz meist richtiger Informationen auch immer Falschinformationen gefunden werden können. Da die User den Unterschied nicht feststellen können, wissen sie nicht, woran sie sind und können sich auf keine Informationen wirklich verlassen.

Folgende Kritikpunkte an der tatsächlichen Qualität der Wikipedia stammen von der Website von Citizendium, die Wikipedia die folgenden Qualitätsmängel bescheinigt:

- Zu viele Artikel sind laienhaft geschrieben

- Zu viele Artikel sind reine unstrukturierte Sammelsurien von Nebensächlichem

- In einigen Themengebieten werden Themen von Gruppen „besetzt gehalten“ um bestimmte Vorurteile wiederzuspiegeln

- Fehlen eines verlässlichen Mechanismus zur Bestätigung von Artikeln

- Wandalismus stets möglich da Beiträge anonym verfasst werden

- Die einflussreichsten sind nicht diejenigen mit dem größten Wissen, sondern mit der meisten Zeit

Zahlen und Untersuchungen zur Qualität von Wikimedia

Wandalismus

Ein Wiki-Projekt zum Thema Wandalismus-Auswertung ist hierzu finden.

Es folgen Zitate aus aktuellen Analysen, die sich mit der Verbreitung von Wandalismus in Wikipedia-Artikeln beschäftigen:

- "The Collaborative Organization of Knowledge" (2008) - Eine von Diomidis Spinellis und Panagiotis Louridas durchgeführte Studie, die herausfand, dass "4% aller Artikeländerungen in der Kurzbeschreibung mit 'Wiederherstellen' gekennzeichnet - eine typische Reaktion auf Wandalismus. Dies passierte im Durchschnitt 13 Stunden nach der vorhergehenden Änderung. Sucht man nach Artikeln mit mindestens einem Wiederherstellungskommentar, sind 11% aller Wikipedia-Artikel mindestens einmal Wandalismus zum Opfer gefallen" [3]

- Eine neue Untersuchung, die auf foundation-l gepostet wurde befand:

- Betrachtet man nur dieses Jahr, war Wandalismus 0,21% der Zeit präsent (0,27% des gesamten Wikipedia-Verlaufs)

- Die zeitliche Dauer von Wandalismus ist teilweise ausufernd; die Medianzeit bis zur Wiederherstellung beträgt 6,7 Minuten, durchschnittlich beträgt sie 18,2 Stunden (eine Wiederherstellung in den untersuchten Artikeln dauerte 45 Monate)

- Fast 50% der Wiederherstellungen geschehen innerhalb von 5 Minuten

- Die 5% der Wandalismusfälle, die mehr als 35 Stunden dauern, sind verantwortlich für 90% des von Besuchern zufällig entdeckten Wandalismus

Mehr zusammenfassende Daten findet man hier

Die Originalveröffentlichung auf foundation-l isthier

Wenn 4% aller Artikelbearbeitungen Wiederherstellungen sind, aber nur 0,27% der Artikel an einem beliebigen Zeitpunkt Wandalismusfälle sind, heißt das, dass eine kleine Anzahl von Artikeln sogar mehrere Fälle von Wandalismus enthält?

Qualität nach Thema/Kategorie

Liste von Untersuchungen, die den Inhalt der Wikipedia mit dem alternativer Anbieter vergleichen:

- Reference Services Review (2008) – „Comparison of Wikipedia and other encyclopedias for accuracy, breadth, and depth in historical articles“[4] (Vergleich von Wikipedia und anderen Enzyklopädien in Hinsicht auf Genauigkeit, Umfang und Fülle in geschichtlichen Artikeln)

Eine Gegenüberstellung von neun Wikipedia-Artikeln zu Geschichtsthemen und vergleichbaren Artikeln aus der Encyclopedia Britannica, dem Dictionary of American History und der American National Biography Online. Die Artikel wurden hinsichtlich Tiefgründigkeit, Genauigkeit und Detailliertheit verglichen.

Auch wenn diese Stichprobe zugegebenermaßen sehr klein war, „offenbarte die Studie Ungenauigkeiten in acht der neun Wikipedia-Artikel und deckte in mindestens zwei Artikeln schwerwiegendere Fehler auf. Insgesamt betrug die Genauigkeitsrate der Wikipedia 80%, gegenüber 95% bis 96% in den anderen Quellen. Diese Studie belegt die Behauptung, dass Wikipedia weniger verlässlich ist als andere Quellen. Außerdem fand die Untersuchung direkte Zitate ohne Quellenangabe und wortgleiche Textstellen aus anderen Quellen ohne als Zitat markiert zu sein”

- PC Pro (2007) – Wikipedia Uncovered: Wikipedia vs. The Old Guard [5] (Wikipedia aufgedeckt: Wikipedia vs. die Altgedienten)

Um Wikipedia mit Britannica.com and Encarta zu vergleichen, bat PC Pro „drei Fachleute, Artikel, die zu ihrem Fachgebiet gehörten, zu bewerten, um uns eine unwissenschaftliche Momentaufnahme der konkurrierenden Quellen zu geben“.

Es wurden Artikel aus Geschichte, Chemie und Geologie bewertet. Bei den vier Artikeln erreichte die Wikipedia einmal die beste Leistung (ein Chemie-Artikel über Arteriosklerose). Auffällig ist, dass die Kommentare zu den Wikipedia-Artikeln je nach Gebiet und Thema stark variierten, beispielsweise:

- „Größerer Nutzen für ernsthafte Studenten als Encarta oder Britannica.“

- „Weitgehend den Tatsachen entsprechend.“

- „Für reine Fakten gut, aber nicht angenehm zu lesen.“

- „Merkliches Nachlassen zum Ende hin.“

- The Denver Post (2007) – “Grading Wikipedia” (Einstufung der Wikipedia)

- Nature (2005) – Internet Encyclopedias go head to head (Internet-Enzyklopädien liegen Kopf an Kopf)

Weitere Zahlen/Untersuchungen

Liste von weiteren Untersuchungen zur inhaltlichen Qualität der Wikipedia:

- „Comparing featured article groups and revision patterns correlations in Wikipedia“ (2009)

(Vergleich von Exzellenten Artikel-Gruppen und Zusammenhänge mit Bearbeitungsmustern)

- „Automatically Assessing the Quality of Wikipedia Articles“ (2008)

(Automatische Beurteilung der Qualität von Wikipedia-Artikeln)

- „Assessing the value of cooperation in Wikipedia“ (2007)

(Bewertung des Stellenwerts von Zusammenarbeit in der Wikipedia)

- „The Quality of Open Source Production: Zealots and Good Samaritans in the Case of Wikipedia“ (2007)

(Die Qualität von Open-Source-Werken: Zeloten und barmherzige Samariter im Falle der Wikipedia)

- „An empirical examination of Wikipedia’s credibility“ (2006)

(Eine empirische Überprüfung der Glaubwürdigkeit der Wikipedia)

- Have you seen the page at w:Wikipedia:External peer review? --Philippe 02:44, 31 July 2009 (UTC), originally posted on the English version of this page.

Welche Initiativen zur Qualitätskontrolle/-sicherung gibt es bereits oder werden gerade getestet?

Überblick über derzeitige Maßnahmen zur Qualitätskontrolle

Wikimedia und die Wikimedia-Gemeinschaft benutzen oder experimentieren zurzeit mit mehreren Maßnahmen zur Qualitätskontrolle und -sicherung:

- Bots

- Freiwillige zur Wandalismusbekämpfung

- Interne Begutachtungen („Lesenswerte“ und „Exzellente Artikel“)

- Externe Begutachtungen

- WikiDashboard(Ed Chi und seine Mitabeiter von PARC)

- Sichten und Prüfen von Artikeln

Weiterführende Zahlen und Forschungen

Sichten und Prüfen von Artikeln

Hier ist ein Link zu Daten, die die Sichtungszeiten für anonym verfasste Beiträge zur deutschen Wikipedia vom 01.01.09 bis 01.06.09 zeigen:

Welche Kontroll-/Sicherungs-Maßnahmen könnte Wikimedia erwägen, um die tatsächliche und empfundene Qualität zu steigern?

Forscher, Community-Mitglieder und alternative Anbieter weisen darauf hin, dass der Wikipedia eine Vielzahl von Möglichkeiten zur Verbesserung der tatsächlichen und empfundenen Qualität offenstehen. Hier wurde eine Liste von vorgeschlagenen Optionen gestartet:

- Sichtbare Hinweise, um Benutzern zwischen wahrscheinlich korrekten und wahrscheinlich unkorrekten Inhalten unterscheiden zu helfen (e.g. Farbkodierung des Textes je nach Vertrauenswürdigkeit)

- Ausweitung von Artikelsichtungen auf Wikipedias in anderen Sprachen

- Zulassen mehrerer Versionen von Artikeln zum selben Thema

- Hinführung zu einem zentralen Editierprozess

- Trennung in „stabile“ und „experimentelle“ Wikipedia

Wie alternative Anbieter diese Methoden umsetzen

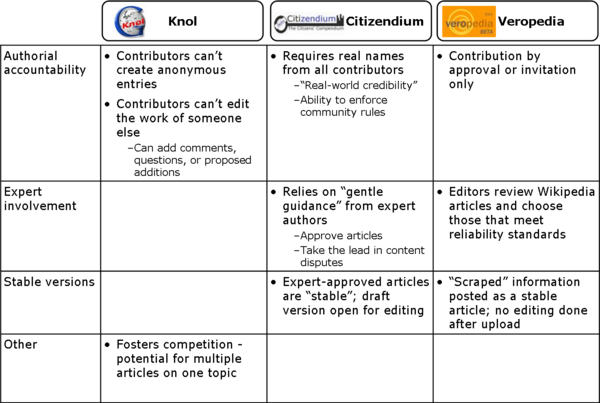

Alternative Anbieter von Wikimedia-ähnlichen Inhalten haben Varianten von vielen dieser Methoden bereits angewendet. Hier wurde begonnen, Informationen darüber zu sammeln (von den Webauftritten der Anbieter):

Welchen möglichen Einfluss haben diese Maßnahmen zur Qualitätsgewährleistung?

Wo sind die größten Schnittflächen zwischen Inhalt und Qualität?

Suche nach Anregungen

- Welche weiteren Rahmen zur Qualitätsbestimmung von Wikimedia gibt es? Welche Kriterien sind besonders zu berücksichtigen?

- Welche anderen Untersuchungen beschäftigen sich mit der Qualität (oder Qualitätsproblemen) von Wikimedia-Inhalten?

- Welche weiteren Maßnahmen wurden bereits ausprobiert oder diskutiert? Liegen Zahlen vor, die den Erfolg und/oder die Grenzen dieser Maßnahmen belegen?

Fußnoten

- ↑ Garfinkel, Simson L., "Wikipedia and the Meaning of Truth", Technology Review, November/Dezember 2008. http://www.technologyreview.com/web/21558/?a=f

- ↑ Cross, Tom, "Puppy smoothies: Improving the reliability of open, collaborative wikis" http://outreach.lib.uic.edu/www/issues/issue11_9/cross/index.html

- ↑ Spinellis and Louridas, "The Collaborative Organization of Knowledge", Communications of the ACM, August 2008 [1]

- ↑ [2]

- ↑ [3]